2013 - Alhambra

- 1808 Núcleos

- 36,75 TFLOPS

- 4,28 TB RAM

- 72 TByte

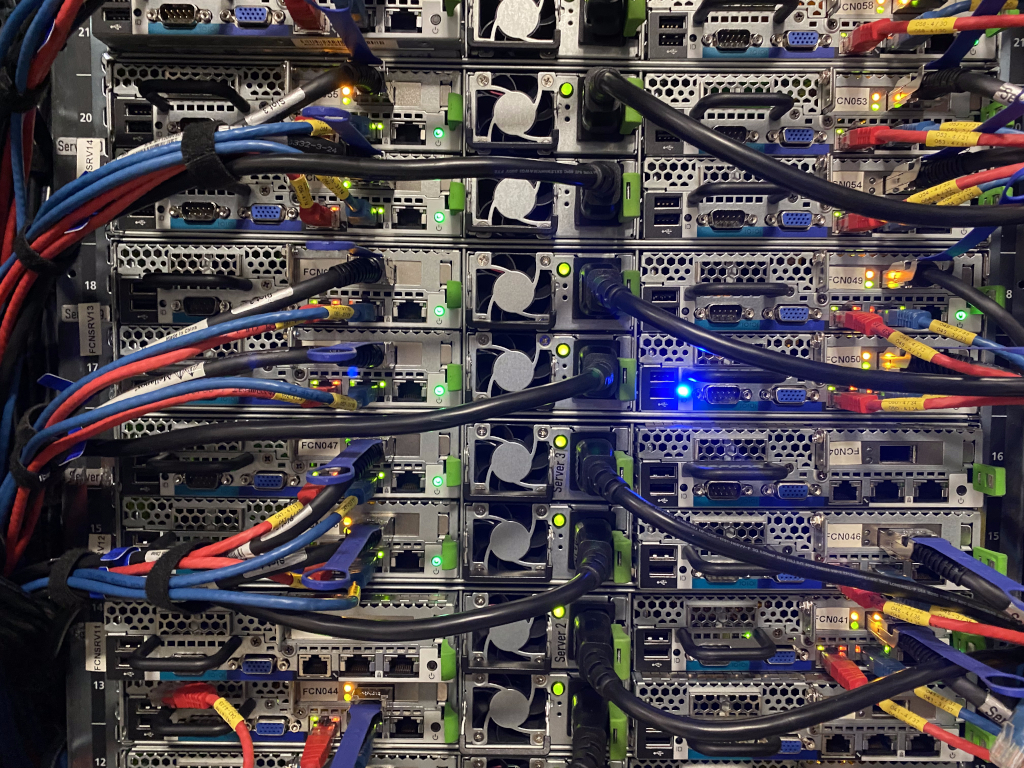

Es un sistema de HPC, adquirido en 2013, compuesto por nodos Fujitsu PRIMERGY CX250/RX350/RX500 y que incorpora 1808 núcleos (3616 hebras en total), 4,28 TByte de memoria RAM, 72 TByte de almacenamiento compartido e interconexión Infiniband QDR.

Descripción

El supercomputador Alhambra, ampliación de UGRGrid, se compone de un total de 109 servidores de cálculo, agrupados en tres tipos:

- 100 nodos modelo Fujitsu Primergy CX250, con 16 cores y 32 GB de memoria RAM

- 4 nodos modelo Fujitsu Primergy RX500, con 32 cores y 256 GB de RAM para cálculos con grandes necesidades de memoria

- 5 nodos modelo Fujitsu Primergy RX350, con 16 cores y 2 tarjetas GPU NVIDIA Tesla, para programas que saquen provecho del uso de GPUs

Todos los nodos están conectados entre sí a través de dos tipos de red, Infiniband QDR y Ethernet GigaLAN. La primera está destinada a la comunicación derivada del cálculo, y proporciona velocidades de transferencia de hasta 40 Gbit/s, y una latencia de 100 ns.

El sistema de almacenamiento se compone de tres cabinas de almacenamiento DX-90, que exportan sus volúmenes a través de Lustre File System.

En total, estos nodos suman 1808 núcleos de proceso, con 4.4 TByte de memoria RAM y 44 TByte de almacenamiento útiles en disco.

Cálculo

Todos los servidores de cálculo llevan incorporados procesadores Intel Xeon SandyBridge con velocidades de reloj de 2.7 y 2.4 GHz. Estos procesadores soportan el bus PCI-E 3.0 y pueden efectuar 8 operaciones de coma flotante por cada ciclo de reloj. Tenemos tres tipos de servidores:

- 4 procesadores Intel Xeon E5-4640, con 8 cores cada uno a 2.4 GHz

- 256 GB RAM DDR3-1600

- 1 interfaz Infiniband QDR

- 4 interfaces de red Gigabit Ethernet

- 2 procesadores Intel Xeon E5-2680, con 8 cores cada uno a 2.7 GHz

- 32 GB RAM DDR3-1600

- 1 interfaz Infiniband QDR

- 4 interfaces de red Gigabit Ethernet

- Tamaño de 1/2 U

- 2 procesadores Intel Xeon E5-2680, con 8 cores cada uno a 2.7 GHz

- 32 GB RAM DDR3-1600

- 1 interfaz Infiniband QDR

- 4 interfaces de red gigabit ethernet

- 2 GPU NVidia Tesla C2075

Almacenamiento

El nucleo de la red de almacenamiento del Servicio de Supercomputación a día de hoy se conforma por equipos del superordenador Alhambra

Actualmente el servicio se ofrece un total de 72 TByte de almacenamiento bruto, distribuidos en tres cabinas independientes, con canales de 64 Gbps y una elevada tasa de transacciones I/O. Una vez configurados los volúmenes, la capacidad estimada de disco útil es de 40 TByte.

Los usuarios disponen de dos tipos de almacenamiento de trabajo, uno para guardar datos permanentes y otro para datos temporales. El primero se denominará directorio de datos permanente y al segundo directorio temporal de trabajo. En este último será desde donde ejecutará sus aplicaciones. Cada grupo de investigación y usuario posee un espacio propio dentro de cada tipo de espacio para guardar sus datos.

El directorio de almacenamiento permanente es donde las aplicaciones deben guardar sus datos una vez haya terminado su ejecución. Tenga en cuenta que el espacio de almacenamiento temporal es limitado y compartido con otros usuarios, por lo que terminado el cálculo, debe transferir los ficheros de salida que desee guardar a su directorio de datos permanentes o a su ordenador personal. De lo contrario, estaría perjudicando el rendimiento global del sistema y en concreto a los otros usuarios. Asimismo, los archivos a los que no se haya accedido en los últimos 20 días se borrarán automáticamente.

Redes

Basada en Infiniband QDR, su misión es procurar que las aplicaciones paralelas que utilizan memoria distribuida puedan establecer la comunicación entre los nodos de cálculo de un modo rápido y con una tasa de transferencia elevada.

Su principal ventaja reside en su mayor ancho de banda (hasta 32 Gb/s frente a 1 Gb/s de Gigabit Ethernet) y, sobre todo, su latencia mucho menor (unos 0.1 µs), lo que es necesario cuando se precisa una comunicación incesante entre los nodos de cálculo.